Nvidia tiết lộ thời điểm xuất xưởng chip B200 giá gần 1 tỉ đồng được Meta mong đợi

Thế giới số - Ngày đăng : 13:14, 20/03/2024

Nvidia tiết lộ thời điểm xuất xưởng chip B200 giá gần 1 tỉ đồng được Meta mong đợi

Cổ phiếu Nvidia tăng giá sau khi công ty thông báo chip AI hàng đầu mới B200 Blackwell dự kiến sẽ xuất xưởng vào cuối năm 2024 và Giám đốc điều hành Jensen Huang cho biết ông đang theo đuổi một thị trường trung tâm dữ liệu có tiềm năng lớn hơn 250 tỉ USD.

Theo Nvidia, B200 Blackwell có tốc độ xử lý một số tác vụ nhanh hơn 30 lần so với phiên bản trước là H100.

Cổ phiếu Nvidia đã tăng gần 2% cuối ngày 19.3 (giờ Mỹ) sau khi ông Jensen Huang và Giám đốc tài chính Colette Kress trả lời câu hỏi từ các nhà đầu tư tại hội nghị nhà phát triển thường niên của công ty ở thành phố San Jose (bang California, Mỹ). Trước đó, cổ phiếu Nvidia giảm gần 4% vào đầu ngày 19.3 sau khi Nvidia trình làng B200 Blackwell mà một số nhà phân tích cho rằng không gây ra sự ngạc nhiên.

“Chúng tôi nghĩ rằng sẽ tung ra thị trường B200 Blackwell vào cuối năm nay”, bà Colette Kress nói.

Ông Jensen Huang ước tính rằng các công ty vận hành trung tâm dữ liệu sẽ chi hơn 250 tỉ USD mỗi năm để nâng cấp chúng bằng các bộ tăng tốc tính toán mà Nvidia chuyên phát triển. Giám đốc điều hành Nvidia nói rằng thị trường này đang tăng trưởng tới 25% một năm.

Nvidia đang chuyển từ bán chip AI đơn lẻ sang bán toàn bộ hệ thống, có khả năng giành được phần lớn hơn của chi phí trong các trung tâm dữ liệu.

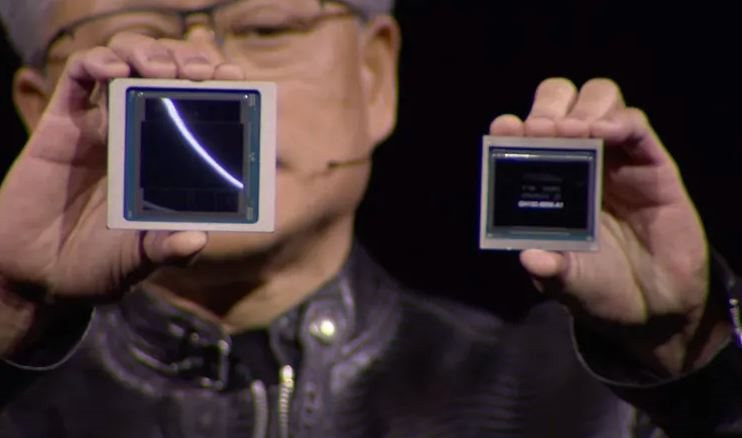

B200 Blackwell được kết hợp hai ô silicon có kích thước tương tự như sản phẩm trước đó và liên kết chúng lại với nhau thành một thành phần duy nhất.

Giới thiệu chip B200 nhanh hơn 30 lần trong các tác vụ như đưa ra câu trả lời từ chatbot AI nhưng ông Jensen Huang không đưa ra chi tiết cụ thể về hiệu quả hoạt động của nó khi xử lý lượng dữ liệu khổng lồ để đào tạo các chatbot đó. Đây là yếu tố chủ yếu giúp doanh số bán hàng của Nvidia tăng vọt.

Ông Jensen Huang nói Nvidia đang hợp tác với TSMC (nhà sản xuất chip theo hợp đồng số 1 thế giới) để tránh tắc nghẽn trong việc đóng gói chip, từng làm chậm việc giao các chip AI hàng đầu trước đây của hãng.

Tỷ phú 61 người Mỹ nói: “Lần trước nhu cầu tăng khá mạnh, nhưng lần này, chúng tôi đã có đủ tầm nhìn về nhu cầu cho các chip Blackwell”.

Ông Jensen Huang nói với trang CNBC rằng chip B200 Blackwell sẽ có giá từ 30.000 đến 40.000 USD (gần 1 tỉ đồng). Sau đó, ông nói rằng Nvidia sẽ đưa B200 Blackwell vào các hệ thống máy tính lớn hơn và giá sẽ thay đổi tùy theo giá trị mà chúng mang lại.

David Wagner, Giám đốc danh mục đầu tư tại hãng Aptus Capital Advisors, nhận xét: “Công nghệ Blackwell cho thấy bước tiến lớn về hiệu suất so với Hopper (chip H100 hàng đầu hiện tại) nhưng luôn khó để đạt được kỳ vọng”.

Trong cuộc thảo luận về sự hợp tác giữa Nvidia với các nhà sản xuất chip nhớ Hàn Quốc, ông Jensen Huang cho biết Nvidia đang kiểm định chất lượng và khả năng hoạt động của chip nhớ băng thông cao (HBM) từ Samsung Electronics. Tuần trước, Reuters đưa tin dòng chip HBM3 của Samsung Electronics vẫn chưa vượt qua quá trình kiểm định của Nvidia để ký kết các hợp đồng cung cấp

SK Hynix, đối thủ cùng quê hương của Samsung Electronics, hôm 19.3 thông báo đã bắt đầu sản xuất hàng loạt chip HBM3E thế hệ tiếp theo, với các nguồn tin cho biết các lô hàng đầu tiên sẽ đến Nvidia trong tháng 3 này.

Giữa tâm điểm hưng phấn về AI của Phố Wall, cổ phiếu Nvidia đã tăng hơn gấp ba lần trong 12 tháng qua, khiến nó trở thành công ty có giá trị thứ ba trên thị trường chứng khoán Mỹ, chỉ sau Microsoft và Apple.

Nvidia cho biết các khách hàng lớn gồm Amazon, Google, Microsoft, OpenAI và Oracle dự kiến sẽ sử dụng chip B200 Blackwell trong các dịch vụ điện toán đám mây mà họ cung cấp, cũng như các dịch vụ AI riêng.

Các nhà phân tích tại hãng Morningstar nói các sản phẩm phần cứng của Nvidia có thể vẫn là “tốt nhất” trong ngành AI, đồng thời nâng ước tính về doanh thu trung tâm dữ liệu của Nvidia vào năm 2026 và 2028. Họ cho biết: “Chúng tôi vẫn ấn tượng với khả năng của Nvidia trong việc phát triển các sản phẩm và nền tảng phần cứng, phần mềm cũng như mạng lưới bổ sung”.

Dù được biết đến rộng rãi nhờ phần cứng, Nvidia cũng sản xuất một lượng đáng kể các sản phẩm phần mềm.

Các công cụ phần mềm mới của Nvidia, được gọi là microservices, cải thiện hiệu quả hệ thống trên nhiều mục đích sử dụng khác nhau, giúp doanh nghiệp dễ dàng kết hợp mô hình AI vào công việc của mình hơn, giống như một hệ điều hành máy tính tốt có thể giúp những ứng dụng hoạt động tốt.

Ngoài phần mềm AI, Nvidia còn đi sâu hơn vào phần mềm mô phỏng thế giới vật lý bằng mô hình 3D. Với công việc thiết kế ô tô, máy bay phản lực và sản phẩm, ông Jensen Huang đã công bố sự hợp tác giữa Nvidia với các công ty cung cấp phần mềm thiết kế Ansys, Cadence và Synopsys. Cổ phiếu ba công ty này tăng giá sau những bình luận của Giám đốc điều hành Nvidia.

Ông Jensen Huang cho biết phần mềm của Nvidia sẽ có thể truyền tải thế giới 3D tới kính thực tế hỗn hợp Apple Vision Pro.

Việc thúc đẩy mảng phần mềm cho thấy Nvidia, công ty cung cấp chip AI chủ yếu được sử dụng để đào tạo các mô hình ngôn ngữ lớn như GPT của OpenAI và Gemini của Google, đang cố gắng làm cho phần cứng của mình dễ dàng thích ứng hơn với các công ty đang gấp rút tích hợp AI vào hoạt động kinh doanh.

Nhiều nhà phân tích cho rằng thị phần của Nvidia sẽ giảm vài điểm phần trăm trong năm 2024 do các đối thủ cạnh tranh tung ra sản phẩm mới và các khách hàng lớn nhất của công ty tự sản xuất chip. Thế nhưng, sự thống trị của Nvidia trên thị trường chip AI khó có thể vượt qua.

Nhà phân tích Jason Bourne của hãng Insider Intelligence nhận xét: “Các đối thủ như AMD, Intel, công ty khởi nghiệp và thậm chí cả tham vọng chip từ chính Big Tech (hãng công nghệ lớn) có thể làm mất đi thị phần của Nvidia, đặc biệt là với những khách hàng doanh nghiệp quan tâm đến chi phí”.

Meta mong đợi nhận lô hàng B200 Blackwell đầu tiên vào cuối năm 2024

Meta Platforms mong đợi sẽ nhận được lô hàng B200 Blackwell đầu tiên vào cuối năm 2024, theo một phát ngôn viên của công ty mẹ Facebook.

Gã khổng lồ truyền thông xã hội Meta Platforms là một trong những khách hàng lớn nhất của Nvidia, sau khi mua hàng trăm ngàn chip H100 để hỗ trợ phát triển các hệ thống đề xuất nội dung được nâng cấp và các sản phẩm AI tạo sinh.

Mark Zuckerberg, Giám đốc điều hành Meta Platforms, vào tháng 1 tiết lộ rằng công ty dự kiến có khoảng 350.000 chip H100 trong kho dự trữ của mình vào cuối năm 2024. Theo Mark Zuckerberg, kết hợp với số GPU từ các nhà cung cấp khác, Meta Platforms sẽ có tổng cộng khoảng 600.000 GPU cuối năm 2024. Khi hoàn thành, Meta Platforms sẽ sở hữu một trong những hệ thống lớn nhất trong ngành công nghệ.

Trong một tuyên bố hôm 19.3, Mark Zuckerberg nói Meta Platforms có kế hoạch sử dụng B200 Blackwell để đào tạo các mô hình AI Llama của công ty. Meta Platforms đang đào tạo Llama 3 dựa trên hai cụm GPU mà hãng công bố vào tuần trước, mỗi cụm chứa khoảng 24.000 GPU H100.

Meta Platforms đã lên kế hoạch tiếp tục sử dụng hai cụm GPU này để huấn luyện Llama 3 và sẽ dùng B200 Blackwell cho các thế hệ mô hình tương lai.