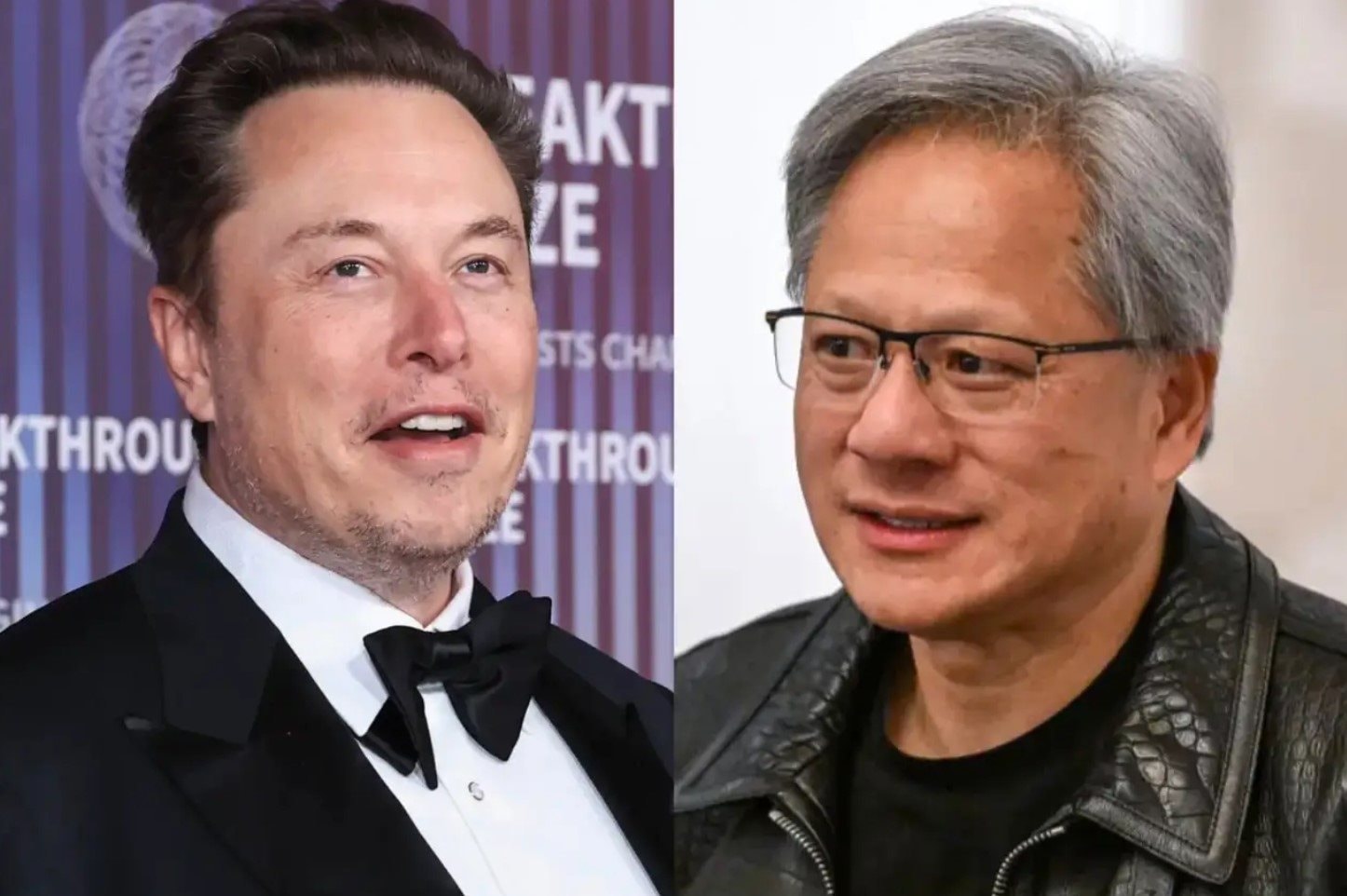

Jensen Huang: Chỉ có Elon Musk xây dựng được siêu máy tính AI với 100.000 GPU Nvidia H100 trong 19 ngày

Nhịp đập khoa học - Ngày đăng : 23:08, 14/10/2024

Jensen Huang: Chỉ có Elon Musk xây dựng được siêu máy tính AI với 100.000 GPU Nvidia H100 trong 19 ngày

Jensen Huang ca ngợi Elon Musk sau khi công ty khởi nghiệp xAI xây dựng siêu máy tính trong 19 ngày, một nỗ lực mà Giám đốc điều hành Nvidia cho biết đáng ra sẽ mất nhiều năm.

Trong tập podcast Bg2 Pod phát sóng hôm 13.10, Jensen Huang nhấn mạnh rằng đó là nỗ lực "siêu phàm" của Elon Musk để xây dựng siêu máy tính AI ở thành phố Memphis (bang Tennessee, Mỹ) trong khoảng thời gian ngắn như vậy.

Giám đốc điều hành Nvidia cho biết: "Theo như tôi biết, chỉ một người trên thế giới có thể làm được điều đó. Elon là người duy nhất hiểu biết về kỹ thuật, xây dựng, hệ thống lớn và huy động tài nguyên. Thật không thể tin được".

xAI đã xây dựng siêu máy tính có tên Colossus, từ một cụm gồm 100.000 bộ xử lý đồ họa (GPU) Nvidia H100. Elon Musk, Giám đốc điều hành xAI, tuyên bố Colossus đại diện cho "hệ thống đào tạo AI mạnh mẽ nhất thế giới".

Hồi tháng 9, Elon Musk cho biết trong một bài đăng trên X rằng phải mất 122 ngày "từ đầu đến cuối" để đưa cụm đào tạo AI trực tuyến, ám chỉ đến tổng thời gian của dự án, và sẽ "tăng gấp đôi quy mô" (lên 200.000 GPU) trong vài tháng khi có thêm nhiều GPU hơn.

Jensen Huang khen ngợi các nhóm kỹ thuật, phần mềm, mạng và cơ sở hạ tầng của xAI và gọi họ là "phi thường".

Trong cuộc phỏng vấn với Jordan Peterson trên X hồi tháng 6, Elon Musk tiết lộ mất 19 ngày để đưa Colossus từ cài đặt phần cứng đến khi bắt đầu đào tạo AI.

Jordan Peterson là nhà tâm lý học lâm sàng, triết gia chính trị, giáo sư tâm lý học nổi tiếng người Canada. Ông được biết đến rộng rãi qua những quan điểm của mình về các vấn đề xã hội, văn hóa, và tâm lý học.

Jensen Huang bình luận về Colossus: "Để dễ hình dung, 100.000 GPU đó dễ dàng là siêu máy tính nhanh nhất trên hành tinh khi xét theo một cụm. Một siêu máy tính mà bạn xây dựng thường mất 3 năm để lên kế hoạch, sau đó họ giao thiết bị và mất 1 năm để đưa mọi thứ vào hoạt động".

Ra mắt năm 2023, xAI đã phát hành phiên bản mới nhất chatbot AI Grok-2 vào tháng 8. Hồi tháng 5, xAI thông báo đã huy động được 6 tỉ USD trong vòng gọi vốn mới.

Larry Ellison, nhà đồng sáng lập và Chủ tịch hãng Oracle, kể vào tháng 9 rằng ông đã dùng bữa tối với Elon Musk và Jensen Huang tại thành phố Palo Alto (bang California, Mỹ), nơi hai người bạn lâu năm "cầu xin" Giám đốc điều hành Nvidia cung cấp thêm GPU.

Larry Ellison kể họ nói với Jensen Huang: "Xin hãy lấy tiền của chúng tôi. Chúng tôi cần anh lấy thêm tiền của chúng tôi" trước khi bông đùa rằng: "Mọi việc diễn ra ổn thỏa, thành công".

Nvidia và Elon Musk không trả lời ngay lập tức các câu hỏi từ trang Insider.

Việc đưa Colossus trực tuyến đánh dấu một bước quan trọng cho tham vọng AI của Elon Musk, đặc biệt là có thể bắt kịp đối thủ ở Thung lũng Silicon là Mark Zuckerberg.

Tham vọng của Mark Zuckerberg và Elon Musk phụ thuộc vào GPU hiệu suất cao, cung cấp sức mạnh tính toán cần thiết cho các mô hình AI mạnh mẽ. Trong trường hợp của Elon Musk là biến xAI thành một công ty thúc đẩy "sự hiểu biết chung của chúng ta về vũ trụ" với Grok.

Những GPU Nvidia không thực sự dễ kiếm và cũng không hề rẻ.

Sự cường điệu được tạo ra xung quanh AI kể từ khi ChatGPT ra mắt vào cuối năm 2022 đã khiến các công ty phải tranh giành GPU Nvidia, với tình trạng thiếu hụt bắt nguồn từ nhu cầu lớn và hạn chế về nguồn cung. Trong một số trường hợp, H100 được bán với giá lên tới hơn 40.000 USD (gần 1 tỉ đồng).

Các công ty đã tìm cách đảm bảo nguồn cung GPU Nvidia theo bất kỳ cách nào có thể và đưa chúng vào hoạt động để vượt lên trước đối thủ bất chấp những rào cản tiếp cận chúng.

Nathan Benaich, người sáng lập kiêm đối tác chung của hãng Air Street Capital, đã theo dõi số lượng Nvidia H100 được các hãng công nghệ mua lại. Ông ước tính tổng số Nvidia H100 mà Meta Platforms hiện có là 350.000, còn xAI là 100.000. Tesla, một trong những công ty khác của Elon Musk, hiện có 35.000 Nvidia H100.

Microsoft, OpenAI và Amazon chưa tiết lộ quy mô của các kho dự trữ H100 của họ.

Meta Platforms chưa tiết lộ chính xác Mark Zuckerberg có được bao nhiêu GPU từ mục tiêu 600.000 của mình và bao nhiêu GPU đã được đưa vào sử dụng. Song trong một bài báo nghiên cứu được công bố vào tháng 7, công ty mẹ Facebook cho biết phiên bản lớn nhất của mô hình ngôn ngữ lớn Llama 3 đã được đào tạo trên 16.000 Nvidia H100.

Hồi tháng 3, Meta Platforms công bố "một khoản đầu tư lớn vào tương lai AI của công ty" với hai cụm 24.000 GPU để hỗ trợ phát triển Llama 3.

Cụm đào tạo AI mới nhất của xAI, với 100.000 GPU Nvidia H100, lớn hơn nhiều so với cụm được sử dụng để đào tạo Llama 3.

Thành tích của Elon Musk thu hút sự chú ý trong làng công nghệ. Một bài đăng trên X từ tài khoản trung tâm dữ liệu của Nvidia để phản hồi Elon Musk: "Thật thú vị khi thấy Colossus, siêu máy tính GPU lớn nhất thế giới, hoạt động trực tuyến trong thời gian kỷ lục".

Greg Yang, đồng sáng lập xAI, có phản ứng sống động hơn với tin tức này bằng trích đoạn lời bài hát của rapper Tyga (Mỹ).

Shaun Maguire, đối tác tại công ty đầu tư mạo hiểm Sequoia, viết trên X rằng đội ngũ xAI hiện "có quyền tiếp cận cụm đào tạo AI mạnh mẽ nhất thế giới" để xây dựng phiên bản tiếp theo của chatbot Grok. Ông nói thêm: "Grok-2 đã tăng tốc để ngang bằng với các mô hình tiên tiến nhất".

Song giống như hầu hết các công ty AI, vẫn còn nhiều dấu hỏi lớn về việc thương mại hóa công nghệ này.

"Thật ấn tượng khi xAI có thể huy động được nhiều tiền như vậy với Elon Musk và đạt được tiến triển, nhưng chiến lược sản phẩm của họ vẫn chưa rõ ràng", Nathan Benaich, nói với trang Insider.

Hồi tháng 7, Elon Musk cho biết phiên bản tiếp theo của Grok (sau khi đào tạo trên 100.000 H100) "sẽ thực sự là một thứ gì đó đặc biệt".

Không phải ai cũng ấn tượng với hệ thống đào tạo AI mạnh nhất thế giới của Elon Musk

Colossus rất mạnh mẽ và có thể giúp Elon Musk bắt kịp những người đi đầu trong ngành AI. Thế nhưng, một số doanh nhân công nghệ nổi tiếng lại không chắc chắn điều này.

Reid Hoffman, nhà đồng sáng lập LinkedIn, nói với trang The Information rằng siêu máy tính của xAI chỉ là "bước khởi đầu" trong lĩnh vực AI tạo sinh đầy cạnh tranh.

Theo The Information, Reid Hoffman muốn nói rằng Colossus chỉ cho phép xAI bắt kịp các công ty AI tiên tiến hơn như OpenAI và Anthropic.

Chris Lattner, Giám đốc điều hành Modular AI, bình luận trong một cuộc thảo luận nhóm tại Hội nghị thượng đỉnh AI của The Information rằng việc Elon Musk phụ thuộc nhiều vào chip đắt tiền và hữu hạn từ Nvidia không phù hợp với nỗ lực của tỷ phú này trong việc xây dựng dự án riêng mang tên Dojo.

Meta Platforms, Microsoft, Alphabet và Amazon đều đang phát triển chip AI riêng ngay cả khi họ vẫn tiếp tục tích trữ GPU Nvidia.

"Điểm khác biệt là Elon đã làm việc trên Dojo trong nhiều năm nay", Chris Lattner nói với trang Insider.

Elon Musk từng bày tỏ lo ngại về những thách thức trong việc mua thêm nhiều chip AI rất được săn đón từ Nvidia và cho biết dự án Dojo sẽ giúp giảm sự phụ thuộc của công ty ông vào hãng sản xuất chip này.

"Chúng tôi thấy một con đường để cạnh tranh với Nvidia bằng Dojo. Chúng tôi không có lựa chọn nào khác", tỷ phú giàu nhất thế giới nói trong buổi báo cáo kết quả kinh doanh của Tesla hồi tháng 7.

Không rõ Colossus có chạy 100.000 GPU cùng lúc hay không, điều này đòi hỏi công nghệ mạng tinh vi và rất nhiều điện năng.

"Elon Musk trước đây nói rằng cụm máy tính 100.000 chip đã được đưa vào hoạt động vào cuối tháng 6. Song vào thời điểm đó, một công ty điện địa phương công khai tuyên bố rằng xAI chỉ có thể tiếp cận vài megawatt điện từ lưới điện địa phương", The Information đưa tin.

Tháng 8, trang CNBC cho biết một nhóm bảo vệ môi trường phàn nàn rằng xAI đã chạy tuabin khí để sản xuất thêm điện cho trung tâm dữ liệu mà không được phép. Tuabin khí là loại động cơ nhiệt được sử dụng để chuyển đổi năng lượng nhiệt thành năng lượng cơ học. Nói một cách đơn giản, nó là máy móc biến nhiệt lượng từ việc đốt cháy nhiên liệu thành chuyển động quay.

Theo CNBC, Trung tâm Luật Môi trường miền Nam viết trong một lá thư gửi đến Sở y tế địa phương rằng xAI đã lắp đặt và đang vận hành ít nhất 18 tuabin không được cấp phép "với khả năng có thêm nhiều tuabin nữa" để bổ sung nhu cầu năng lượng khổng lồ của mình.

Memphis Light, Gas and Water (công ty điện lực địa phương) nói với CNBC rằng đã cung cấp 50 megawatt điện cho xAI kể từ đầu tháng 8, nhưng cơ sở này cần thêm 100 megawatt để vận hành.

Các nhà phát triển cụm dữ liệu nói với The Information rằng điều này chỉ có thể cung cấp điện cho vài ngàn GPU. xAI sẽ cần một trạm biến áp điện khác để có đủ điện để chạy 100.000 GPU.