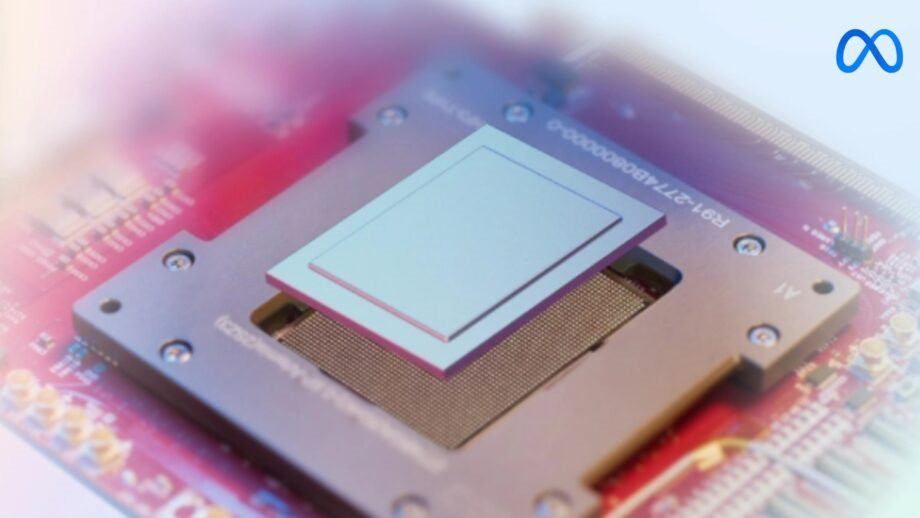

Meta Platforms vừa tiết lộ thông tin chi tiết về chip tăng tốc trí tuệ nhân tạo (AI) nội bộ mang tên MTIA (Meta Training and Inference Accelerator).

Đầu năm nay, Reuters đưa tin Meta Platforms đã lên kế hoạch triển khai phiên bản mới của chip trung tâm dữ liệu tùy chỉnh để giải quyết lượng sức mạnh tính toán ngày càng tăng cần thiết để chạy các sản phẩm AI trên Facebook, Instagram và WhatsApp. Chip này, có tên nội bộ là Artemis, sẽ giúp Meta Platforms giảm sự phụ thuộc vào chip AI Nvidia cũng như giảm chi phí dùng năng lượng nói chung.

Meta Platforms viết trong một bài đăng trên blog: “Kiến trúc của chip này về cơ bản tập trung vào việc cung cấp sự cân bằng phù hợp giữa tính toán, băng thông bộ nhớ và dung lượng bộ nhớ để phục vụ các mô hình xếp hạng và đề xuất”.

MTIA là một phần trong nỗ lực tùy chỉnh chip của công ty, gồm cả việc xem xét các hệ thống phần cứng khác. Ngoài việc xây dựng chip và phần cứng, Meta Platforms còn đầu tư đáng kể vào việc phát triển phần mềm cần thiết để khai thác sức mạnh của cơ sở hạ tầng theo cách hiệu quả nhất.

TSMC (hãng sản xuất chip theo hợp đồng số 1 thế giới) sẽ sản xuất chip MTIA trên quy trình 5 nanomet của mình. Meta Platforms cho biết MTIA có khả năng đạt hiệu suất gấp ba lần so với chip thế hệ đầu tiên.

Chip MTIA đã được triển khai trong trung tâm dữ liệu và tham gia phục vụ các ứng dụng AI. Meta Platforms cho biết họ có một số chương trình đang được tiến hành "nhằm mở rộng phạm vi MTIA, gồm cả hỗ trợ khối lượng công việc AI tạo sinh".

AI tạo sinh là một loại AI có mục tiêu chính là tạo ra thông tin mới, thường thông qua quá trình học máy và học sâu. Loại AI này không chỉ giải quyết các nhiệm vụ cụ thể, mà còn có khả năng tạo ra dữ liệu, văn bản, hình ảnh, âm thanh, video và nhiều loại thông tin khác.

Một ví dụ nổi tiếng về AI tạo sinh là mô hình ngôn ngữ lớn GPT của OpenAI. GPT có khả năng tạo ra văn bản mới, dựa trên dữ liệu mà nó đã được huấn luyện trước đó.

Công ty mẹ Facebook cũng chi hàng tỉ USD để mua chip AI của Nvidia và các hãng khác.

Mark Zuckerberg, Giám đốc điều hành Meta Platforms, cho biết công ty có kế hoạch mua khoảng 350.000 chip H100 từ Nvidia. Ông nói kết hợp với các nhà cung cấp khác, Meta Platforms có kế hoạch tích lũy số lượng tương đương 600.000 chip H100 trong năm 2024.

Thông báo về MTIA đến khi Meta Platforms chuẩn bị phát hành mô hình AI tiên tiến hơn, có khả năng suy luận, giúp giải quyết vấn đề và đảm nhận các nhiệm vụ phức tạp hơn.

Joelle Pineau, Phó chủ tịch nghiên cứu AI tại Meta Platforms, nói công ty đang "làm việc chăm chỉ" để tìm ra cách giúp mô hình nói chuyện, lập luận, lập kế hoạch và có trí nhớ.

Giúp các mô hình AI có khả năng suy luận và lập kế hoạch là một bước quan trọng để đạt được AI tổng quát (AGI), điều mà cả Meta Platforms và OpenAI đều tuyên bố đang hướng tới. AGI là AI siêu thông minh, tiên tiến đến mức có thể làm được nhiều việc ngang bằng hoặc tốt hơn con người.

Sự phát triển này có thể đáng giá hàng nghìn tỉ USD cho công ty đạt được điều đó. Hồi tháng 2, John Carmack (cựu lãnh đạo Meta Platforms và người tiên phong về thực tế ảo) đã gọi AGI là “mục tiêu lớn lao” về AI. Ông tuyên bố AGI sẽ trở thành ngành công nghiệp nghìn tỉ USD vào những năm 2030.

Meta Platforms và những gã khổng lồ công nghệ khác đang nỗ lực tìm kiếm nguồn dữ liệu mới để đào tạo mô hình AI thế hệ mới.

Google, Meta Platforms và OpenAI (được Microsoft hậu thuẫn) ban đầu sử dụng miễn phí dữ liệu lấy từ internet để đào tạo các mô hình AI tạo sinh có thể bắt chước khả năng sáng tạo của con người. Họ nói rằng làm như vậy vừa hợp pháp vừa có đạo đức, dù phải đối mặt với các vụ kiện từ nhiều chủ sở hữu bản quyền về hành vi này.

Ngoài ra, các hãng công nghệ nêu trên cũng đang âm thầm trả tiền cho nội dung bị ẩn sau tường phí và màn hình đăng nhập, dẫn đến hoạt động giao dịch ngầm về mọi thứ, từ nhật ký trò chuyện đến ảnh cá nhân bị lãng quên từ lâu trên các ứng dụng mạng xã hội cũ.

Intel và Google giới thiệu chip AI mới

Hôm 9.4, Intel đã trình bày chi tiết về phiên bản mới chip AI Gaudi 3 tại sự kiện Vision nhắm vào vị thế thống trị của Nvidia trong lĩnh vực bán dẫn cung cấp năng lượng cho AI.

Các hãng công nghệ đang săn lùng một nguồn thay thế chip khan hiếm cần thiết cho AI. Intel cho biết chip mới Gaudi 3 của hãng có khả năng đào tạo một mô hình ngôn ngữ lớn cụ thể nhanh hơn 50% so với chip Nvidia H100.

Gaudi 3 cũng có khả năng tính toán các phản hồi AI tạo sinh, quá trình được gọi là suy luận, nhanh hơn so với Nvidia H100 với một số mẫu mà Intel đã thử nghiệm.

Tuy nhiên vào tháng trước, Nvidia đã trình làng chip AI mới B200 Blackwell có tốc độ xử lý một số tác vụ nhanh hơn 30 lần so với H100. Nvidia thông báo B200 Blackwell dự kiến sẽ xuất xưởng vào cuối năm 2024. Ông Jensen Huang, Giám đốc điều hành Nvidia, nói với trang CNBC rằng B200 Blackwell sẽ có giá từ 30.000 đến 40.000 USD (gần 1 tỉ đồng). Song sau đó, ông nói rằng Nvidia sẽ đưa B200 Blackwell vào các hệ thống máy tính lớn hơn và giá sẽ thay đổi tùy theo giá trị mà chúng mang lại.

Jeni Barovian, Phó chủ tịch phụ trách chiến lược và quản lý sản phẩm của Intel, nói: “Ưu tiên hàng đầu của khách hàng chúng tôi là yêu cầu có sự lựa chọn trong ngành. Họ đang tìm đến chúng tôi và mong đợi rằng Intel, với tư cách là nhà tiên phong về điện toán, sẽ đi theo làn sóng AI tạo sinh và cung cấp các giải pháp đáp ứng nhu cầu của họ. Họ đang tìm kiếm một cách tiếp cận cởi mở".

Intel và AMD đã phải vật lộn để tạo ra một chip hấp dẫn và phần mềm cần thiết để xây dựng các ứng dụng AI có thể trở thành giải pháp thay thế khả thi cho Nvidia. Nvidia kiểm soát khoảng 83% thị trường chip trung tâm dữ liệu vào năm 2023, phần lớn trong số 17% còn lại thuộc về các bộ xử lý tensor (TPU) tùy chỉnh của Google mà hãng này không bán trực tiếp.

TSMC sẽ sử dụng quy trình 5 nanomet để chế tạo chip Gaudi 3.

Gaudi 3 gồm hai chip xử lý chính được hợp nhất với nhau và nhanh hơn gấp đôi phiên bản trước đó. Gaudi 3 được thiết kế để kết hợp với hàng ngàn chip khác và khi thực hiện như vậy có thể tạo ra một lượng sức mạnh tính toán khổng lồ.

Gaudi 3 sẽ có sẵn cho các nhà xây dựng máy chủ như Supermicro và Hewlett Packard Enterprise vào quý 2/2024.

Hôm 9.4, Google công bố Axion, CPU dựa trên kiến trúc arm tùy chỉnh, để hỗ trợ AI hoạt động trong các trung tâm dữ liệu.

Axion hiện hỗ trợ quảng cáo YouTube, Google Earth Engine và các dịch vụ khác của Google. Theo Thomas Kurian, Giám đốc phụ trách đám mây của Google, máy chủ ảo chứa Axion có hiệu suất cao hơn 50% so với máy ảo tương đương dựa trên mô hình x86 của Intel. Axion cũng mang lại hiệu suất cao hơn 30% so với máy ảo dùng chip arm đa năng nhanh nhất hiện nay trên đám mây.

Động thái này cho thấy Google đang cố gắng bắt kịp các đối thủ như Amazon và Microsoft, vốn áp dụng chiến lược này trong nhiều năm. Các hãng công nghệ có trung tâm dữ liệu đang cạnh tranh quyết liệt trên thị trường cơ sở hạ tầng đám mây, nơi các tổ chức, doanh nghiệp thuê dịch vụ đám mây từ xa và trả tiền theo mức sử dụng.

Quảng cáo vẫn đang chiếm ba phần tư doanh thu của Alphabet (công ty mẹ của Google) nhưng mảng đám mây đang tăng trưởng mạnh với gần 11%. Dù vậy, Google vẫn đi sau Amazon và Microsoft trong lĩnh vực này.

Hiện dẫn đầu thị trường đám mây, Amazon đã giới thiệu chip Graviton arm năm 2018. Chirag Dekate, nhà phân tích tại hãng Gartner, nói đa số dịch vụ của Amazon đã được tối ưu hóa trên hệ sinh thái arm. Theo Chirag Dekate, việc giới thiệu Axion sẽ giúp Google hoàn thiện danh mục đầu tư của công ty.

Mark Lohmeyer, Phó chủ tịch kiêm Giám đốc cơ sở hạ tầng máy tính và học máy Google Cloud, nói với Reuters: "Axion được xây dựng trên nền tảng mở nhưng khách hàng có thể dễ dàng sử dụng mà không cần kiến trúc lại hoặc viết lại ứng dụng của họ".