Các thành phần máy tính thường không được kỳ vọng sẽ biến đổi toàn bộ doanh nghiệp và ngành công nghiệp, nhưng một bộ xử lý đồ họa (GPU) của Nvidia ra mắt vào năm 2023 đã làm được điều đó.

Chip trung tâm dữ liệu H100 giúp vốn hóa thị trường của Nvidia tăng thêm hơn 1.000 tỉ USD và biến công ty này trở thành “vua trí tuệ nhân tạo (AI)”. Điều này cho các nhà đầu tư thấy rằng thông tin xung quanh AI tạo sinh đang chuyển thành doanh thu thực sự, ít nhất là với Nvidia và những nhà cung cấp quan trọng nhất của hãng. Nhu cầu về H100 lớn đến mức một số khách hàng phải đợi tới 6 tháng mới nhận được GPU này.

Sau báo cáo kết quả kinh doanh quý 4/2023 vượt kỳ vọng, cổ phiếu của Nvidia đã tăng mạnh lên mức 818,75 USD. Vốn hóa thị trường của Nvidia hiện là hơn 2.030 tỉ USD, chỉ sau Microsoft và Apple ở Mỹ.

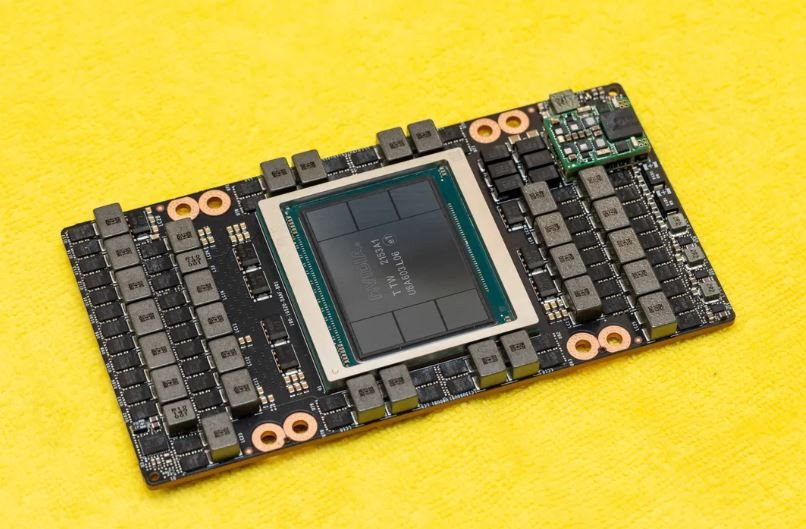

1. Nvidia H100 - GPU mạnh nhất trên thị trường

H100, cái tên gợi nhớ đến nhà tiên phong về khoa học máy tính Grace Hopper, là GPU mạnh mẽ hơn loại chip thường tích hợp trong máy tính cá nhân để giúp game thủ có được trải nghiệm hình ảnh chân thực nhất. Thế nhưng, H100 đã được tối ưu hóa để xử lý khối lượng lớn dữ liệu và tính toán ở tốc độ cao, khiến nó hoàn toàn phù hợp cho nhiệm vụ đào tạo mô hình AI tiêu tốn nhiều năng lượng.

H100 hiện là GPU mạnh nhất trên thị trường, đồng thời cũng có giá đắt đỏ, khoảng 25.000 - 36.000 USD và khi khan hàng có thể lên đến 40.000 USD (gần 1 tỉ đồng).

Được thành lập vào năm 1993, Nvidia đã đi tiên phong trong thị trường GPU với các khoản đầu tư có niên đại gần hai thập kỷ, khi hãng đặt cược rằng khả năng thực hiện công việc song song một ngày nào đó sẽ khiến chip của họ trở nên có giá trị trong các ứng dụng ngoài chơi game.

2. Vì sao H100 lại đặc biệt đến vậy?

Các nền tảng AI tạo sinh học cách hoàn thành các nhiệm vụ như dịch văn bản, tóm tắt báo cáo và tổng hợp hình ảnh thông qua việc đào tạo dựa trên các bộ dữ liệu có sẵn. Càng được đào tạo nhiều, chúng càng trở nên giỏi hơn trong những việc như nhận dạng giọng nói của con người hoặc viết thư xin việc.

Các nền tảng AI tạo sinh phát triển thông qua quá trình trial and error, thực hiện hàng tỉ nỗ lực để đạt được trình độ thành thạo và tiêu tốn một lượng lớn sức mạnh tính toán trong đó.

Trial and error là phương pháp học tập và giải quyết vấn đề dựa trên việc thử nghiệm các cách khác nhau, phân tích kết quả và điều chỉnh cho đến khi đạt được mục tiêu mong muốn.

Nvidia cho biết H100 nhanh hơn 4 lần so với phiên bản tiền nhiệm là A100 trong việc đào tạo những mô hình ngôn ngữ lớn và phản hồi nhanh hơn 30 lần với lời gợi ý của người dùng. Với các công ty đang chạy đua đào tạo mô hình ngôn ngữ lớn để thực hiện các nhiệm vụ mới, lợi thế hiệu suất đó có thể rất quan trọng.

3. Nvidia trở thành công ty dẫn đầu về AI như thế nào?

Có trụ sở ở thành phố Santa Clara (bang California, Mỹ), Nvidia là công ty hàng đầu thế giới về chip đồ họa, thành phần của máy tính tạo ra hình ảnh bạn nhìn thấy trên màn hình. Các chip mạnh mẽ nhất trong số đó được xây dựng với hàng trăm lõi xử lý thực hiện nhiều luồng tính toán đồng thời, mô phỏng các hiện tượng vật lý phức tạp như bóng đổ và phản chiếu.

Các kỹ sư Nvidia vào đầu những năm 2000 nhận ra rằng họ có thể trang bị lại bộ tăng tốc đồ họa cho những ứng dụng khác bằng cách chia nhiệm vụ thành các phần nhỏ hơn và sau đó thực hiện chúng cùng lúc. Chỉ hơn một thập kỷ trước, các nhà nghiên cứu AI đã phát hiện ra rằng công việc của họ cuối cùng có thể trở thành hiện thực bằng cách sử dụng loại chip này.

4. Nvidia liệu có đối thủ thực sự?

Nvidia kiểm soát khoảng 80% thị trường GPU trong các trung tâm dữ liệu AI được điều hành bởi AWS của Amazon, Google Cloud của Alphabet, Azure của Microsoft… Những nỗ lực nội bộ của các công ty này nhằm xây dựng chip riêng và sản phẩm cạnh tranh từ những nhà sản xuất chip như AMD hay Intel đến nay vẫn chưa tạo được nhiều ấn tượng trên thị trường chip AI.

5. Nvidia đi trước các đối thủ cạnh tranh như thế nào?

Nvidia đã nhanh chóng cập nhật các dịch vụ của mình, gồm cả phần mềm hỗ trợ phần cứng, với tốc độ mà chưa có hãng nào sánh kịp. Công ty cũng nghĩ ra nhiều hệ thống cụm khác nhau để giúp khách hàng mua H100 với số lượng lớn và triển khai chúng nhanh chóng.

Các chip như bộ xử lý Intel Xeon có khả năng xử lý dữ liệu phức tạp hơn, nhưng có ít lõi hơn Nvidia H100 và chậm hơn nhiều trong việc xử lý khối lượng thông tin khổng lồ thường được sử dụng để đào tạo phần mềm AI. Bộ phận trung tâm dữ liệu của Nvidia công bố doanh thu tăng 81% lên mức 22 tỉ USD trong quý 4/2023.

6. AMD và Intel chạy theo Nvidia như thế nào?

AMD, nhà sản xuất chip đồ họa máy tính lớn thứ hai, đã tiết lộ phiên bản dòng Instinct vào tháng 6.2023 nhắm vào thị trường mà các sản phẩm Nvidia thống trị.

Lisa Su, Giám đốc điều hành AMD, nói với khán giả tại một sự kiện ở thành phố San Francisco (Mỹ) rằng chip MI300X này có nhiều bộ nhớ hơn để xử lý khối lượng công việc cho AI tạo sinh.

"Chúng ta vẫn đang ở giai đoạn rất, rất sớm trong vòng đời của AI", bà nói vào tháng 12.2023.

Intel đang đưa các chip dành riêng cho công việc AI ra thị trường nhưng thừa nhận rằng hiện tại, nhu cầu với chip đồ họa trung tâm dữ liệu đang tăng nhanh hơn so với các CPU vốn là thế mạnh của họ. Ưu thế của Nvidia không chỉ nằm ở hiệu suất phần cứng của họ. Nvidia đã phát minh ra CUDA, ngôn ngữ chip đồ họa cho phép lập trình chúng cho loại công việc hỗ trợ các chương trình AI.

7. Nvidia dự định phát hành sản phẩm gì tiếp theo?

Trong năm 2024, Nvidia H100 sẽ được kế thừa bởi thế hệ tiếp theo là H200. Đây là bước đệm trước khi Nvidia thực hiện những thay đổi lớn hơn với mẫu B100.

H200 đi kèm với bộ nhớ băng thông cao hơn và có thể giúp Nvidia duy trì vị trí dẫn đầu, bất kể AMD sắp ra mắt chip MI300. Nvidia cho biết H200 được triển khai vào năm nay với Amazon, Google và Oracle.

Nâng cấp chính ở H200 là tăng bộ nhớ băng thông cao (HBM), một trong những thành phần đắt nhất của chip quyết định khả năng xử lý dữ liệu nhanh chóng.

Theo Nvidia, sự ra đời của H200 sẽ tạo ra những bước nhảy vọt về hiệu suất, trong đó hãng nhấn mạnh đến khả năng suy luận của các mô hình AI dữ liệu lớn. Thử nghiệm với mô hình ngôn ngữ lớn Llama 2 của Meta Platforms với 70 tỉ tham số, H200 mang đến hiệu suất gần gấp đôi so với H100.

Nvidia cho biết H200 sẽ có khả năng sử dụng HBM3e, xử lý tốt hơn các tập dữ liệu lớn cần thiết để phát triển và triển khai AI.

H200 có HBM 141 GB, tăng từ 80 GB ở H100 trước đó. Nvidia không tiết lộ nhà cung cấp bộ nhớ trên chip H200, nhưng Micron Technology (hãng chip nhớ số 1 Mỹ) nói vào tháng 9.2023 rằng đang nỗ lực để trở thành nhà cung cấp cho Nvidia.

Nvidia cũng mua bộ nhớ từ Samsung Electronics và SK Hynix (hai hãng chip nhớ hàng đầu thế giới của Hàn Quốc).

Jensen Huang, Giám đốc điều hành Nvidia, đã đóng vai trò là đại sứ cho công nghệ và tìm cách thuyết phục các chính phủ cũng như doanh nghiệp tư nhân sớm mua GPU nếu không có nguy cơ bị những hãng theo đuổi AI bỏ lại phía sau.