Tại hội nghị nhà phát triển Ignite sáng 16.11 ở thành phố Seattle (bang Washington, Mỹ), Microsoft đã giới thiệu hai chip AI được thiết kế tùy chỉnh.

Microsoft cho biết không có kế hoạch bán hai chip này mà thay vào đó sẽ sử dụng chúng để cung cấp sức mạnh cho các dịch vụ phần mềm đăng ký của riêng mình và như một phần của dịch vụ điện toán đám mây Azure.

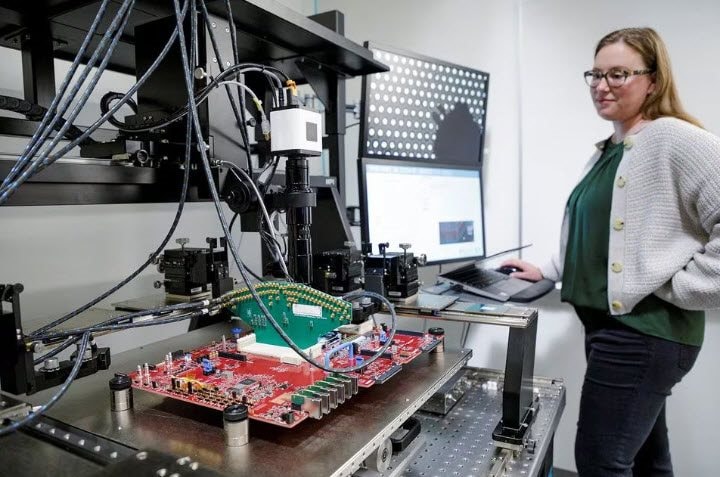

Tại hội nghị nhà phát triển Ignite, Microsoft đã giới thiệu một chip mới có tên Maia để tăng tốc các tác vụ điện toán trí tuệ nhân tạo (AI) và cung cấp nền tảng cho dịch vụ Copilot giá 30 USD/tháng với người dùng phần mềm doanh nghiệp cũng như các nhà phát triển muốn để tạo ra các dịch vụ AI tùy chỉnh.

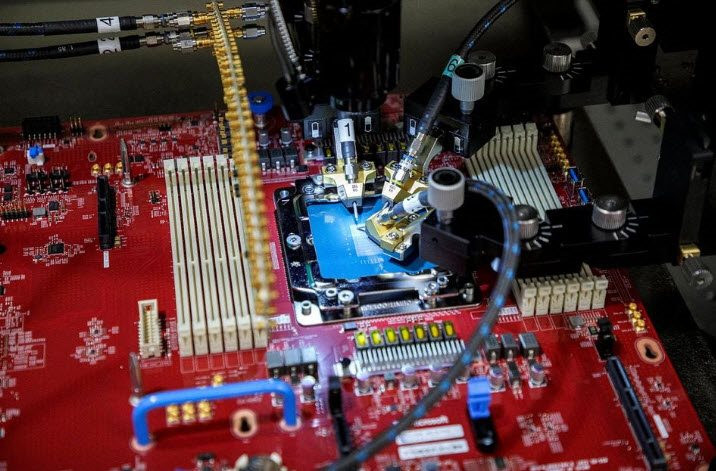

Chip Maia được thiết kế để chạy các mô hình ngôn ngữ lớn, loại phần mềm AI làm nền tảng cho dịch vụ Azure OpenAI của Microsoft và là sản phẩm hợp tác giữa Microsoft với OpenAI.

OpenAI là công ty khởi nghiệp phát triển ChatGPT, được Microsoft đầu tư hàng tỉ USD.

Microsoft và những gã khổng lồ công nghệ khác, gồm cả Alphabet, đang phải vật lộn với chi phí cao khi cung cấp dịch vụ AI, có thể lớn hơn 10 lần so với các dịch vụ truyền thống như công cụ tìm kiếm.

Các lãnh đạo Microsoft cho biết có kế hoạch giải quyết vấn đề chi phí đó bằng cách thực hiện gần như toàn bộ nỗ lực sâu rộng nhằm đưa AI vào các sản phẩm của công ty thông vào một bộ mô hình AI nền tảng chung. Họ nói rằng chip Maia được tối ưu hóa cho công việc đó.

Scott Guthrie, Phó chủ tịch điều hành nhóm đám mây và AI của Microsoft, nói: “Chúng tôi nghĩ rằng điều này mang lại cho chúng tôi một cách để có thể cung cấp các giải pháp tốt hơn cho khách hàng của mình với tốc độ nhanh hơn, chi phí thấp hơn và chất lượng cao hơn”.

Microsoft tiết lộ vào năm tới sẽ cung cấp cho khách hàng Azure các dịch vụ đám mây chạy trên chip hàng đầu mới nhất của Nvidia và AMD. Microsoft đang thử nghiệm mô hình ngôn ngữ lớn GPT-4 của OpenAI trên chip AMD.

Ben Bajarin, Giám đốc điều hành công ty phân tích Creative Strategies, cho biết: “Chip Maia không phải là thứ có thể thay thế Nvidia”. Ông cho biết chip Maia sẽ cho phép Microsoft bán các dịch vụ AI trên đám mây cho đến khi máy tính cá nhân và smartphone đủ mạnh để xử lý chúng.

“Microsoft có một mô hình kinh doanh đặc biệt và thành công với việc cung cấp các dịch vụ mà người dùng sẵn sàng trả chi phí để sử dụng”, Ben Bajarin nhận xét.

Chip thứ hai của Microsoft được công bố rạng sáng nay được thiết kế vừa để tiết kiệm chi phí nội bộ vừa là câu trả lời cho đối thủ đám mây chính của công ty là Amazon Web Services.

Được đặt tên là Cobalt, chip mới là bộ xử lý trung tâm (CPU) được sản xuất theo công nghệ của Arm Holdings. Microsoft tiết lộ rằng đã thử nghiệm Cobalt để hỗ trợ Teams, công cụ nhắn tin doanh nghiệp của mình.

Thế nhưng, Scott Guthrie nói Microsoft cũng muốn bán quyền truy cập trực tiếp vào Cobalt để cạnh tranh với loạt chip nội bộ Graviton do Amazon Web Services cung cấp.

Scott Guthrie cho biết: “Chúng tôi đang thiết kế giải pháp Cobalt của mình để đảm bảo rằng có khả năng cạnh tranh rất cao cả về hiệu suất cũng như giá cả trên hiệu suất (so với chip của Amazon)”.

Amazon Web Services sẽ tổ chức hội nghị nhà phát triển của riêng mình vào cuối tháng này và một phát ngôn viên công ty cho biết chip Graviton của họ hiện có 50.000 khách hàng.

Người phát ngôn Amazon Web Services nói sau khi Microsoft công bố chip của mình: "Amazon Web Services sẽ tiếp tục đổi mới để cung cấp các thế hệ chip do công ty thiết kế trong tương lai nhằm mang lại hiệu suất về giá thậm chí còn tốt hơn cho bất kỳ khối lượng công việc nào của khách hàng yêu cầu".

Microsoft đã đưa ra một số chi tiết kỹ thuật cho phép đánh giá khả năng cạnh tranh của Maia và Cobalt so với các nhà sản xuất chip truyền thống.

Rani Borkar, Phó chủ tịch tập đoàn phụ trách hệ thống phần cứng và cơ sở hạ tầng Azure, cho biết cả hai chip mới đều được sản xuất bằng công nghệ 5 nanomet của TSMC. TSMC là hãng sản xuất chip theo hợp đồng lớn nhất thế giới, có trụ sở ở Đài Loan.

Rani Borkar nói thêm rằng chip Maia sẽ được kết hợp với mạng cáp Ethernet tiêu chuẩn, thay vì công nghệ mạng Nvidia tùy chỉnh đắt tiền hơn mà Microsoft đã sử dụng trong các siêu máy tính mà hãng xây dựng cho OpenAI. “Bạn sẽ thấy chúng tôi đi theo con đường tiêu chuẩn hóa nhiều hơn”, bà chia sẻ với Reuters.

Cuối tháng 1, Microsoft thông báo mở rộng quan hệ đối tác lâu dài với OpenAI thông qua một “khoản đầu tư mới nhiều năm, nhiều tỉ USD”.

Satya Nadella, Giám đốc điều hành Microsoft, nói: “Chúng tôi đã thiết lập quan hệ đối tác với OpenAI xung quanh tham vọng chung nhằm thúc đẩy nghiên cứu AI tiên tiến một cách có trách nhiệm và dân chủ hóa AI như một nền tảng công nghệ mới. Ở giai đoạn hợp tác tiếp theo của chúng tôi, các nhà phát triển và tổ chức trong các ngành sẽ có quyền truy cập vào cơ sở hạ tầng, mô hình và chuỗi công cụ AI tốt nhất với Azure để xây dựng và chạy các ứng dụng của họ”.

Thỏa thuận này sẽ chứng kiến Microsoft tăng cường đầu tư vào việc phát triển và triển khai các hệ thống siêu máy tính để hỗ trợ nghiên cứu của OpenAI. Phần quan trọng của thỏa thuận: Microsoft là đối tác đám mây độc quyền cho OpenAI. Các dịch vụ đám mây của Microsoft sẽ hỗ trợ tất cả khối lượng công việc của OpenAI trên các sản phẩm, dịch vụ API và nghiên cứu.

Theo hãng tin Reuters, Microsoft đã xây dựng một hệ thống với hơn 10.000 chip Nvidia cho OpenAI để sử dụng trong việc phát triển các công nghệ làm nền tảng cho ChatGPT, cụ thể là GPT (Generative Pre-training Transformer).

Microsoft đã triển khai các mô hình của OpenAI trên nhiều sản phẩm dành cho người tiêu dùng và doanh nghiệp.

Ngoài ra, Microsoft thách thức Google với việc tích hợp ChatGPT vào kết quả tìm kiếm Bing. Nhà sản xuất hệ điều hành Windows còn đưa một số công nghệ AI ngôn ngữ vào các ứng dụng Word, PowerPoint và Outlook của mình.

Microsoft không tiết lộ chính xác số tiền họ đã đầu tư vào OpenAI nhưng đang tìm cách sử dụng mối quan hệ thân thiết này để tiếp tục thương mại hóa dịch vụ Azure OpenAI của mình.

Tin đồn về thỏa thuận này cho thấy Microsoft có thể nhận được 75% lợi nhuận của OpenAI cho đến khi đảm bảo hoàn vốn đầu tư và 49% cổ phần trong công ty. OpenAI cho biết vẫn là một công ty có giới hạn lợi nhuận sau thỏa thuận này, cho phép họ tiếp tục huy động vốn.

Sam Altman, Giám đốc điều hành OpenAI, nói: “Ba năm hợp tác vừa qua của chúng tôi thật tuyệt vời. Microsoft chia sẻ các giá trị của chúng tôi. Chúng tôi rất vui mừng được tiếp tục nghiên cứu độc lập của mình và hướng tới việc tạo ra AI tiên tiến mang lại lợi ích cho mọi người”.

Thế nhưng, trang The Information đưa tin Microsoft đang cố gắng giảm sự phụ thuộc vào OpenAI. The Information cho biết quyết định này phần lớn được thúc đẩy bởi chi phí ngày càng tăng của việc chạy các mô hình AI tiên tiến.

Một nhân viên hiện tại và một cựu nhân viên vừa rời Microsoft nói với The Information rằng một người giám sát 1.500 nhà nghiên cứu tại Microsoft đã hướng dẫn một số người trong số họ phát triển mô hình ngôn ngữ lớn nội bộ.

Nguồn tin nói với The Information rằng Microsoft muốn các mô hình ngôn ngữ lớn nội bộ của mình rẻ hơn và nhỏ hơn so với GPT-4, ngay cả khi điều này có nghĩa là chúng hoạt động không tốt.

Theo The Information, các nhóm sản phẩm đang nỗ lực tích hợp các chương trình AI nội bộ của Microsoft vào các sản phẩm như Bing Chat.

Đại diện của OpenAI và Microsoft không trả lời câu hỏi của trang Insider về chuyện trên.